过去十多年,计算产业的每一次跃迁,几乎都伴随着一次清晰的技术范式变化。从 CPU 到 GPU,从加速计算到云计算,再到大模型训练,产业叙事始终围绕着“性能提升”这一核心指标展开:算力更强、速度更快、成本更低,几乎成为评估技术进步的统一尺度。

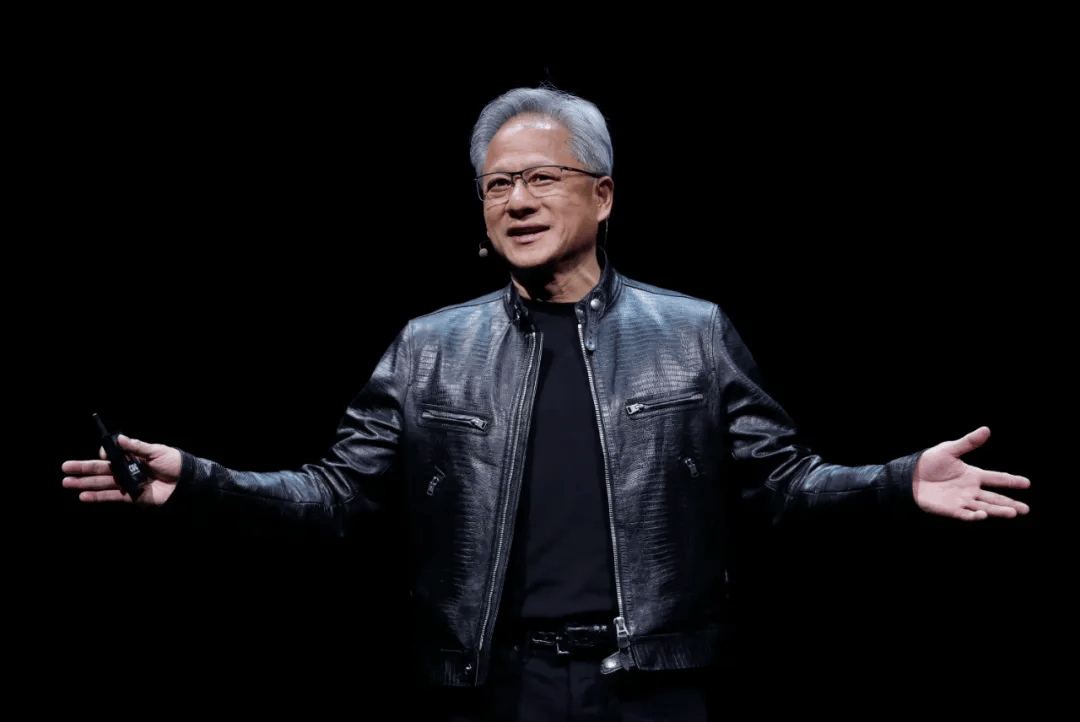

但在 CES 2026 的主题演讲中,黄仁勋反复传递的并不是某一项单点技术的突破,而是一种更深层次的转向:计算正在从“为了训练模型而存在”,走向“为了让智能长期运行而存在”。这不是一次简单的性能升级,而是计算用途本身的结构性变化。

随着生成式 AI 逐步走向规模化落地,推理正在成为最主要、也是最持久的计算负载。与集中式、阶段性的模型训练不同,推理是一种长期存在的需求——模型上线只是开始,真正消耗算力的,是模型在真实业务中持续运行、不断响应请求、参与决策和执行的过程。正是在这一变化之下,数据中心的角色、算力系统的设计目标,乃至整个 AI 技术栈的组织方式,都开始被重新定义。

在黄仁勋的判断中,计算机工业正站在一次结构性重置的门槛上。大约每 10 到 15 年,计算平台就会完成一次跃迁:从大型机到个人电脑,从互联网到云计算,从移动终端到云原生。而当下这一轮变化的核心,不再是终端形态的变化,而是软件与计算方式本身的重构。

AI 成为通用底座之后,软件不再是“写好后运行”的静态程序,而是构建在模型之上的动态系统。应用不再提前生成内容,而是在运行时即时生成 Token、像素和行为路径。每一次运行,都是一次新的“计算过程”。正如黄仁勋所说,未来的软件不是被“执行”,而是被“推理”。

这种变化直接重塑了计算范式。软件的本质从“编写”转向“训练”,运行载体从 CPU 转向 GPU。随着测试时扩展(Test-time Scaling)的出现,模型的“思考过程”本身成为算力消耗的重要组成部分:推理越深,结果越好。这意味着,未来计算的核心指标,不再只是 Token 生成速度,而是持续、复杂的逻辑推演能力。

从模型到应用:AI Agent 作为新一代应用形态

如果说模型解决的是智能从哪里来,那么应用要回答的,是智能如何被使用。在黄仁勋的框架中,AI Agent 正是这轮技术跃迁真正落地到应用层的关键形态。

早期大模型容易产生幻觉,根本原因并不只是模型不够大,而是它们被封闭在训练数据的世界里,无法感知实时信息,也无法与外部系统交互。Agent 的引入,正是为了解决这一问题——让模型在行动之前,先进行判断:是否需要检索信息、是否要调用工具、是否应当拆解任务步骤。

这种“先研究、再行动”的机制,使推理本身成为应用的一部分。模型不再被要求在训练阶段掌握一切知识,而是在具体环境中,通过推理、搜索与规划,动态生成解决路径。多模型协作也随之成为常态:不同模型在同一推理链中各司其职,共同完成任务。

在 NVIDIA 内部,Agent 已经深度参与到研发流程中,显著提升了工程效率。这并不是简单的自动化,而是一种协作关系的变化——从“工具型 AI”,走向“协作型 AI”。应用也不再依赖固定界面,而是通过多轮交互逐步推进任务完成。

更重要的是,这种基于 Agent 的架构,正在显著降低创新门槛。借助开源模型和标准化工具,开发者可以构建具备垂直领域能力的定制化 AI,并通过意图路由机制,将用户请求自动分发给最合适的模型或工具。NVIDIA 将这些关键组件抽象为可复用的“蓝图”,并将其集成进多个企业级平台之中。

在实际落地中,Agent 已不只是对话界面,而是可以直接调用工具、访问系统,甚至控制实体设备。从企业软件到工业系统,Agent 正逐步取代传统表单与命令行,成为新的交互入口。

但在黄仁勋看来,这还只是开始。

当 AI 走出语言世界:物理 AI 的底层逻辑

真正决定 AI 能走多远的,并不是它能否“说得更好”,而是能否理解并作用于真实世界。这正是 NVIDIA 长期投入的方向——物理 AI。

现实世界充满约束与因果关系。要在其中运行,AI 必须理解重力、摩擦、惯性、物体恒存性等最基础的物理常识。这些对人类而言近乎本能的认知,却是 AI 需要重新学习的一整套世界模型。

问题在于,真实世界的数据既昂贵又稀缺,且无法覆盖所有极端与长尾场景。NVIDIA 给出的答案,并不是无限制采集现实数据,而是用计算生成世界本身。在这一逻辑下,模拟不再只是测试工具,而成为物理 AI 的根基。

围绕这一目标,NVIDIA 构建了一套“三台计算机”协同运作的体系:一台用于训练模型,一台用于在汽车、机器人或工厂中运行推理,另一台则专门用于模拟现实世界的物理反馈。Omniverse 构建了遵循物理规律的数字孪生世界,而Cosmos,则进一步将这一能力提升为世界基础模型。

Cosmos 并非语言模型的简单延伸,而是面向物理世界的统一表征系统。它在视频、自动驾驶、机器人和 3D 仿真数据上完成预训练,使语言、视觉、空间与动作得以对齐。更关键的是,它支持闭环模拟——AI 在虚拟世界中的每一次行动,都会立即获得环境反馈,从而判断行为是否合理。

这种能力,让长尾场景不再依赖现实中的“偶然出现”,而是可以被系统性构造、反复演练。计算力,由此直接转化为高质量训练数据,为自动驾驶与机器人提供近乎无限的学习空间。

自动驾驶与机器人:全栈能力的现实落点

在自动驾驶领域,NVIDIA 并未选择局部优化,而是尝试跑通一条完整闭环。Alpamayo,正是这一思路下诞生的端到端自动驾驶模型。

它直接完成从摄像头输入到车辆动作输出的映射,训练数据既包括人类驾驶示范,也包括由 Cosmos 生成的海量虚拟里程。在此基础上,模型不仅“做出决策”,还能解释决策原因,并预测未来轨迹,使驾驶行为更接近经验丰富的本地司机。

更重要的是,Alpamayo 并未孤立运行,而是与一套可验证、可追溯的传统 AV 软件栈并行。系统会根据场景风险动态切换决策路径,这种双栈冗余设计,使其成为少数能够实现端到端安全认证的自动驾驶系统之一。

而在机器人领域,物理 AI 的意义正在被进一步放大。机器人不再通过昂贵的现实试错学习,而是在数字孪生世界中完成“出生—训练—进化”。Omniverse、Isaac 与 Jetson 构成的闭环,让机器人可以在虚拟世界中学习,在现实世界中执行,并持续将经验反馈给模型。

这种范式的变化,正在反向重塑工业体系本身。从芯片设计、系统仿真,到工厂规划与运营,物理 AI 被嵌入整个工业软件栈之中。与 Cadence、Synopsys、Siemens 的合作,并非单点技术整合,而是一次围绕工业全生命周期的系统性重构。

从芯片到系统:NVIDIA 的真正转型

当生成式 AI 进入推理主导阶段,算力增长的逻辑正在发生变化。模型规模仍在扩大,但真正失控的,是推理阶段的计算消耗。在摩尔定律放缓的现实下,单点性能提升已难以支撑这一趋势。

Vera Rubin 架构,正是在这一背景下提出的系统级回应。

值得一提的是,在 NVIDIA 内部,Vera Rubin 并不是一个随意选取的名字。

黄仁勋在 CES 演讲中,特意花了一段时间讲述这位美国天文学家的故事。Vera Rubin 是最早通过观测发现星系边缘旋转速度异常的人之一——按照牛顿力学,越远离中心,旋转速度本应越慢,但事实并非如此。她由此提出了一个颠覆性的判断:宇宙中一定存在某种“看不见的物质”,也就是后来被称为暗物质的存在。

“除非空间中存在我们看不见的东西,否则这一切都无法解释。”黄仁勋用这句话,将天文学的发现与当下的计算困境连接起来。对 NVIDIA 而言,Vera Rubin 这个名字,象征的正是这样一种时刻——当传统物理和既有范式已经无法解释增长时,系统本身必须被重新发明。

Vera Rubin 架构,正是诞生于这样的判断之下。

在生成式 AI 进入推理主导阶段后,算力需求的增长逻辑已经发生质变。模型规模仍在扩张,但真正失控的,是推理阶段的计算消耗。随着 o1 等推理模型的出现,AI 不再是一次性给出答案,而是在运行过程中显式“思考”。为了教会 AI 思考,后训练阶段引入了强化学习,计算机开始通过自我迭代来学习如何完成任务,而不再只是模仿人类示范。

预训练、后训练以及测试时 Scaling Law 叠加在一起,使算力需求呈现出指数级放大。黄仁勋在演讲中指出,测试时Scaling Law 正在推动 Token 生成量以每年约 5 倍的速度增长,而在激烈竞争下,每一代新技术的出现,都会将上一代Token 的成本压低一个数量级。“这是一场极其残酷的竞赛,而归根结底,这是一道计算题。算力越强,抵达下一个前沿的速度就越快。”

问题在于,摩尔定律已经明显放缓。晶体管数量的增长速度,远远追不上模型规模和推理复杂度的扩张。如果仍然沿用“每一代只改一两颗芯片”的节奏,整个行业的性能增长将被物理极限锁死。

这正是 Vera Rubin 架构出现的根本原因。

与以往以单一 GPU 为中心的迭代不同,Vera Rubin 采用的是一种被 NVIDIA 内部称为“极致协同设计(Extreme Co-design)”的方法:六颗全新芯片,被当作一个整体系统同步设计、同步演进。黄仁勋直言:“如果不在整个堆栈的所有芯片上同时创新,行业将无法继续前进。”

在这一架构中,Vera CPU 与 Rubin GPU 从设计源头就实现了深度耦合。Vera 是一颗完全定制的 CPU,在功耗受限条件下实现了前代两倍的性能和能效,专为超级计算与大规模 AI 工作负载而生。Rubin GPU 则在晶体管数量仅增加约 1.6 倍的前提下,实现了浮点性能相较 Blackwell 五倍的跃升。

黄仁勋坦言,“如果仅依赖晶体管数量增长,即便每个晶体管的效率提升 25%,年度性能增幅也难以突破 1.6 倍。这就是为什么我们必须采取极端手段。”

这种“极端手段”,体现在硬件对 AI 计算路径的重构之中。NVFP4 Tensor Core 并不是简单的低精度接口,而是被固化进芯片内部的完整处理单元。Transformer Engine 可以在芯片层面动态调整精度与吞吐,在允许误差的地方释放性能,在关键路径回归高精度计算。这种自适应能力,无法通过软件补救,只能通过系统级协同设计实现。

但 Vera Rubin 的突破,并不止于计算芯片本身。

在系统层面,NVIDIA 同样进行了彻底重构。ConnectX-9 为每颗 GPU 提供超高带宽的横向扩展,BlueField-4 DPU 将存储、安全等任务从主计算路径中卸载,让算力尽可能专注于 AI 本身。第六代 NVLink Switch 将 72 颗 Rubin GPU 连接为一个一致性协同系统,其数据交换能力超过全球互联网总量。

在物理形态上,Vera Rubin 计算节点彻底重塑了 MGX 机箱结构。黄仁勋在现场甚至用略带玩笑的方式强调:“这东西非常重,当 CEO 真的得有个好身体。”但真正重要的,是节点设计的工程意义——零线缆、极简管路、100% 液冷,将原本需要数小时、且容易出错的组装流程,压缩到几分钟内完成。

写在最后

在CES 2026 的整场主题演讲,黄仁勋并没有在强调某一代芯片或某一项产品,而是在系统性地阐述一条产业路径:NVIDIA 正在从芯片、基础设施到模型与应用,全方位重塑 AI 的技术栈。它不再只是为 AI 提供算力,而是在构建一个能够长期、稳定、规模化产出智能的基础设施体系。

这并不是一次短期的产品周期,而是一场长期的工业重构。当计算不再只是算力堆叠,而成为可模拟、可推理、可持续演化的系统,AI 才真正具备走出屏幕、进入现实世界的能力。

正如那位天文学家所揭示的那样——当既有理论无法解释现实,答案往往不在细节修补,而在于对“看不见之物”的重新理解。

京公网安备 11010202008829号

京公网安备 11010202008829号